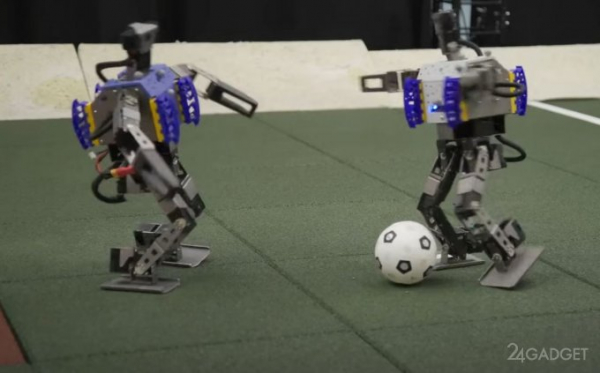

Исследователи DeepMind, подразделения Google, продемонстрировали успехи в сфере обучения роботов двигательным действиям. Команда обучила маленьких двуногих ботов играть в футбол. Исследователи рассказали, как им удалось этого добиться и почему дальше будет только лучше.

Компания обучила роботов игре с помощью метода глубокого обучения с подкреплением — то есть боты обучались обрабатывать неструктурированные данные. Например, это не набор чисел от 1 до 100, а полностью непредсказуемые данные, например, быстроменяющаяся игровая обстановка на игровом поле.

Роботы действуют так, чтобы добиться результата, который в момент обучения был помечен как положительный: к примеру, подняться после падения — это положительный результат. Отличие достижения от других подобных в том, что метод применили к физической координации роботов в пространстве.

Изначально «испытуемых» обучали в компьютерной симуляции с концентрацией на двух задачах: подняться после падения и забить гол. Затем исследователи объединили эти навыки в игре в футбол один на один. Играя всё больше, роботы усовершенствовали свои навыки до состояния, которое и показали на видео.

В число двигательных действий вошли удары ногами, защита, реакция на действия соперника и «прицельная стрельба» по воротам. Также исследователи упоминают, что роботы демонстрируют нестандартное поведение, которое сложно запрограммировать заранее. Но обучение проводили в симуляции, а в будущем компания планирует начать «тренировки» на игровом поле для ещё большего повышения адаптивности поведения.